Nvidia($NVDA)の決算内容

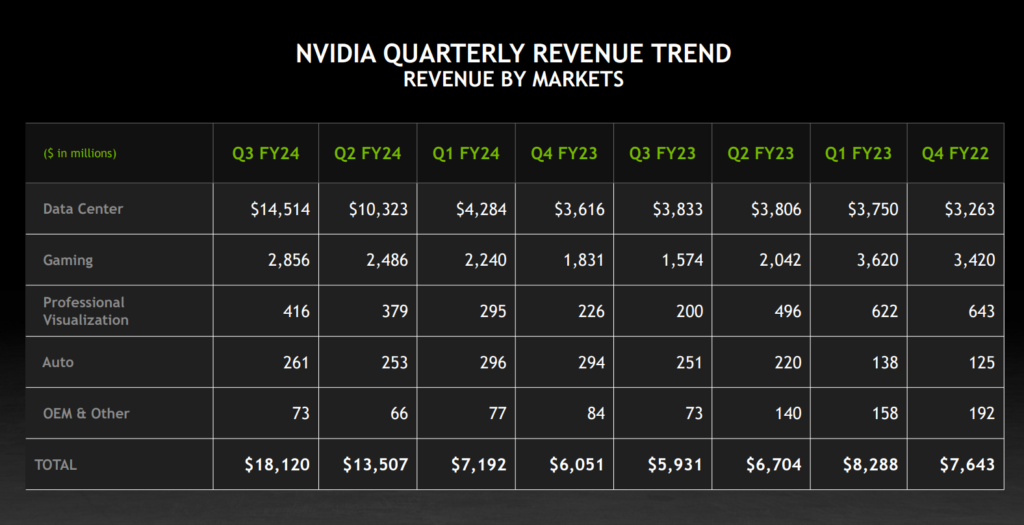

事業別売上推移

決算コール 本文

コレット・クレス — エグゼクティブ・バイスプレジデント兼最高財務責任者

ありがとう、シモーナ。第3四半期も記録的な四半期でした。売上高は1,810万ドルで、前四半期比34%増、前年同期比では200%以上増加し、見通しの160億ドルを大きく上回りました。データセンターから始めますと、当社のHopper Tensor Core GPUアーキテクチャをベースとしたNVIDIA HGXプラットフォームが、InfiniBandエンド・ツー・エンド・ネットワーキングとともに、前四半期比41%増、前年同期比279%増の145億ドルという記録的な収益をもたらしました。

NVIDIA HDXとInfiniBandの組み合わせは、基本的にAIスーパーコンピュータとデータセンター・インフラのリファレンス・アーキテクチャです。最もエキサイティングなジェネレーティブAIアプリケーションのいくつかは、Adobe、Firefly、ChatGPT、Microsoft 365 Copilot、CoAssist、Now Assist with ServiceNow、Zoom AI Companionなど、NVIDIA上で構築・実行されています。データセンターのコンピュート収入は昨年の4倍、ネットワーク収入は約3倍になりました。大規模言語モデル、ディープラーニング・レコメンダーシステム、およびジェネレーティブAIアプリケーションのトレーニングおよび推論のためのインフラへの投資が、NVIDIAアクセラレーテッド・コンピューティングに対する幅広い需要を強力に後押ししています。

推論は現在、NVIDIA AI コンピューティングの主要なワークロードとなっています。コンシューマー・インターネット企業およびエンタープライズは、第 3 四半期に異例の連続成長を遂げ、当社の データセンター収益の約半分を占め、総成長を上回りました。Meta のような企業は、学習型レコメンダー・システムを本格的に稼働させており、また、広告主が画像やテキストを最適化できるよう、AI センターに投資しています。ほとんどの大手消費者向けインターネット企業は、ジェネレーティブAIの導入を急ピッチで進めている。

企業におけるAI導入の波は今、始まっている。Adobe、Databricks、Snowflake、ServiceNowなどのエンタープライズ・ソフトウェア企業は、パイプラインにAIのコパイロットやアシスタントを追加している。また、より広範な企業が、テスラや自律走行などの垂直産業アプリケーション向けにカスタムAIを開発している。クラウドサービスプロバイダーは、当四半期のデータセンター収益の約半分を牽引しました。

需要は、すべてのハイパースケールCSPだけでなく、AIの新しい市場機会に対応するために急速に成長しているGPUに特化したCSPの世界的な拡大セットからも好調でした。NVIDIA H100 Tensor Core GPUインスタンスは、インスタンスと高い需要があるほぼすべてのクラウドで一般的に利用できるようになりました。当社は今年、旺盛な需要に応えるため、四半期ごとに供給量を大幅に増やしており、来年もそれを継続する見込みです。また、拡大し多様化するAIの機会に対応するため、より広範で迅速な製品投入を行う予定です。

当四半期の終わりに、米国政府は中国およびベトナムや中東の特定の国を含むその他の市場に対する新たな輸出管理規制を発表しました。これらの規制により、当社のホッパー、MPIR100および800シリーズをはじめとする多くの当社製品の輸出にライセンスが必要となります。現在ライセンス要件の対象となっている製品から派生する中国およびその他の影響を受ける国への売上は、過去数四半期にわたり一貫してデータセンター売上高の約20%から25%に寄与しています。

第4四半期はこれらの地域への売上が大幅に減少すると予想されますが、他の地域での力強い成長により相殺されるものと考えています。米国政府は、米国業界が中国を含む世界中の市場にデータセンター・コンピューティング製品を提供できるようにするため、この規制を策定した。

規制が奨励するように世界的な競争を続けることは、米国の技術リーダーシップを促進し、経済成長を促し、米国の雇用を支えることになる。最高性能レベルに対しては、政府はライセンスを要求する。

より低い性能レベルに対しては、政府は合理化された事前通知プロセスを要求する。そして、さらに低い性能レベルの製品については、政府は一切の通知を必要としない。政府の明確なガイドラインに従い、当社はデータセンター製品ポートフォリオを拡充し、米国政府が出荷前の事前通知を希望しない製品も含め、各規制カテゴリーに準拠したソリューションを提供できるよう取り組んでいます。

当社は中国や中東の一部の顧客と協力し、米国政府からのライセンス取得を目指している。しかし、これらのライセンスがかなりの収益につながるかどうかを判断するのは時期尚早である。多くの国々が、経済成長と産業革新を支援するために、AIインフラへの投資の必要性に目覚めつつある。

国内の計算能力に投資することで、各国は自国のデータを使ってLLMを訓練し、自国のジェネレーティブAIエコシステムをサポートすることができる。例えば、私たちはインド政府や、インフォシス、リライアンス、タタなどの最大手ハイテク企業と協力して、ソブリンAIインフラを強化しています。また、フランスのプライベートクラウドプロバイダーであるScalewayは、NVIDIA H100、InfiniBand、およびNVIDIA AIエンタープライズソフトウェアをベースとした地域AIクラウドを構築し、フランスとヨーロッパ全域での発展を促進しています。コンピュート容量への国家投資は新たな経済的要請であり、ソブリンAIインフラ市場へのサービスは、今後数年間で数十億ドル規模のビジネスチャンスとなります。

製品面では、第3四半期の収益の大部分は、当社のHopper GPUアーキテクチャに基づくNVIDIA HGXプラットフォームによるもので、前世代のAmpere GPUアーキテクチャの寄与は低かった。業界標準のサーバー向けに構築された新しいL40s GPUは、様々な顧客のトレーニングや推論ワークロードをサポートするために出荷が開始された。また、この四半期は、ARMベースのGrace GPUとHopper GPUを組み合わせたGH 200 Grace Hopper Secretチップの最初の売上四半期でもありました。グレースとグレース・ホッパーは、数十億ドル規模の新たな製品ラインに成長しつつあります。

Grace Hopperインスタンスは現在、GPU専門のクラウド・プロバイダーで利用可能で、Oracle Cloudでも間もなく利用可能になります。Grace Hopperはスーパーコンピューティングの顧客にも大きな支持を得ており、LaSalle、Localimos、National Lab、Swiss National Supercomputing Centerへの初期システム出荷が第3四半期に行われた。英国政府は、約5,500個のグレース・ホッパー・スーパーチップを搭載した世界最速のAIスーパーコンピュータ「Isambard-AI」を構築すると発表した。

ドイツ・スーパーコンピューティング・センター(Elec)も、24,000個近いグレース・ホッパー・スーパーチップとQuantum 2 InfiniBandを搭載した次世代AIスーパーコンピューターを構築すると発表しており、AI性能90エクサフロップスを超える世界最強のAIスーパーコンピューターとなる。来年には、米国、欧州、日本全体でGrace Hopperをベースに構築されたすべてのスーパーコンピューターのAI演算能力を合計すると200エクサフロップスを超え、さらに多くの勝利がもたらされると予測しています。ディープラーニング、レコメンデーション、サーブチャットボット、コピロット、テキスト画像生成など、AIが本格的に稼働しており、データセンターの需要に大きく貢献しています。そして、これは始まりに過ぎません。

NVIDIA AIは、最高の推論性能と汎用性を提供し、その結果、消費電力と所有コストを低減します。私たちはまた、高速なコスト削減カーブを描いています。NVIDIA TensorRT LLMのリリースにより、NVIDIA GPUによるLLM推論の2倍以上の推論性能と半分のコストを達成しました。また、Hopperファミリーの最新メンバーであるBH 200も発表しました。BH 200は、生成AIとLLMをさらに加速するために、HBM3E、より高速でより大きなメモリを提供する最初のGPUとなります。

これは、Lambda2のようなLLMを実行するためのH100 GPUと比較して、推論を最大2倍まで向上させます。TensorRT LLMとH200を組み合わせることで、わずか1年で、性能は4倍向上し、コストは4倍削減されました。これは、CUDAと当社のアーキテクチャ互換性の恩恵です。H100と比較して、H200はGPT-3のような推論モデルで18倍の性能向上を実現し、顧客はより大きなモデルに移行することができ、レイテンシは増加しません。

Amazon Web Services、Google Cloud、Microsoft Azure、Oracle Cloudは、来年からH200ベースインスタンスを提供する最初のCSPのひとつとなる。先週のマイクロソフト・イグナイトでは、我々はマイクロソフトとの協業をより高いレベルで深化・拡大させました。私たちは、Azure上で動作するカスタム生成AIエンタープライズ・アプリケーションの開発とチューニングのためのAIファウンドリー・サービスを発表しました。顧客はドメインの知識や独自のデータを持ち込むことができ、私たちはDGX Cloudで私たちのAI専門知識とソフトウェアスタックを使用してAIモデルの構築を支援します。

SAPとAmdocsは、Microsoft Azure上のNVIDIA AIファウンドリ・サービスの最初の顧客である。さらにマイクロソフトは、H100をベースにした新しい機密コンピューティング・インスタンスを発表する予定です。H100は、最新のMLPerf業界ベンチマークの結果に示されているように、AIトレーニングのためのトップパフォーマンスで最も汎用性の高いプラットフォームであり続け、大差をつけています。当社のトレーニングクラスタには、6月の3倍にあたる10,000個以上のH-100 GPUが含まれており、非常に効率的なスケーリングを反映しています。

LLMは毎年桁違いに増加しているため、効率的なスケーリングは生成AIにおける重要な要件です。Microsoft Azureは、ほぼ同じクラスタで同様の結果を達成し、NVIDIA AIとパブリッククラウドの展開の効率性を実証しました。ネットワーキングは現在、年率100億ドルの収益を上げている。力強い成長の原動力となったのは、前年比5倍増となったInfiniBandへの並外れた需要である。

InfiniBandは、LLMのトレーニングに必要なスケールとパフォーマンスを得るために不可欠である。Microsoftは先週、まさにこの点を強調し、Azureが地球を一周するのに十分な29,000マイル以上のInfiniBandケーブルを使用していることを明らかにしました。私たちは、NVIDIAのネットワーキングをイーサネットの分野にも拡大しようとしています。AIに特化したテクノロジーを搭載した当社の新しいSpectrumエンド・ツー・エンドEthernetは、Dell、HP、Lenovoを含む大手OEMのサポートにより、来年第1四半期に利用可能になる予定です。

Spectrum Xは、従来のイーサネット製品に比べ、AI通信において1.6倍のネットワーク性能を実現します。また、ソフトウェアとサービスについても最新情報をお伝えします。経常的なソフトウェア、サポート、サービスの年間売上高は10億ドルに達する見込みです。中期的な成長機会としては、DGXクラウドサービスとエヌビディアのAIエンタープライズ・ソフトウェアの2つを考えています。

それぞれ、エンタープライズAIトレーニングとエンタープライズAI推論の成長を反映しています。当社の最新のDGX Cloud顧客発表は今朝、GentechとのAI研究コラボレーションの一環として行われました。このバイオテクノロジーのパイオニアは、当社のBionemo-LLMフレームワークを使用して、AI創薬プラットフォームの加速と最適化を支援する予定です。私たちは現在、Adobe、Dropbox、Getty、SAP、ServiceNow、SnowflakeなどとのエンタープライズAIパートナーシップを結んでいます。わかりました。

ゲームに移ります。ゲーム売上は28.6億ドルで、前四半期比15%増、前年同期比80%以上の増収となりました。重要なバック・トゥ・スクールショッピングシーズンに強い需要があり、エヌビディアRTXリトレースとAIテクノロジーが299ドルという低価格帯で利用できるようになりました。私たちは、ゲーマーとクリエイター向けに過去最高のラインナップを揃えてホリデーシーズンを迎えます。ゲーミングは、PC市場の不振を背景に、COVID以前の水準に比べて倍増しています。

これは、RTXやBLSSのようなイノベーションにより、当社がゲーミング・エコシステムに大きな価値をもたらしたことを反映しています。これらの技術をサポートするゲームやアプリケーションの数はこの間に爆発的に増加し、アップグレードを促進し、購入者を引き付けています。RTXエコシステムは成長を続けています。現在、RTX対応のゲームやアプリケーションは475を超えます。

ジェネレーティブAIは、高性能PC、NVIDIA RTX GPU、最も高性能なAI PCやワークステーションを見つけるための新しい柱となるアプリケーションとして急速に浮上しています。私たちは、LLM推論を4倍高速化するTensorRT LLM for Windowsをリリースしたばかりです。1億台以上のインストールベースを持つNVIDIA RTXは、AIアプリケーション開発者にとって当然のプラットフォームです。最後に、当社のGeForce NOWクラウド・ゲーミング・サービスは、勢いを増し続けています。

PCゲームのライブラリは、Alan Wake 2、Baldur’s Gate 3、Cyberpunk 2077、Fantom Liberty、Starfieldの発売を含め、1,700タイトルを超えました。ProVizに移る。売上高は4億1600万ドルで、前四半期比10%増、前年比108%増。NVIDIA RTXは、プロフェッショナルなデザイン、エンジニアリング、シミュレーションのユースケースに選ばれるワークステーションプラットフォームであり、AIが強力な需要ドライバーとして台頭している。

初期のアプリケーションには、ヘルスケアにおけるAI画像処理のための推論や、スマートスペースや公共部門におけるエッジAIなどがあります。当社は、NVIDIA RTXエイダ・ラブレス世代GPUとConnectX、スマートNICをベースとしたデスクトップ・ワークステーションの新ラインを発表し、AI処理、レイトレーシング、グラフィックス性能を旧世代の最大2倍に向上させました。これらの強力な新型ワークステーションは、AIモデルの微調整、小規模モデルのトレーニング、ローカルでの推論実行などのAIワークロードに最適化されています。3D仮想世界の設計、構築、運用のためのソフトウェア・プラットフォームであるOmniverseの開発を引き続き進めています。

メルセデス・ベンツは、Omniverseのパワー・デジタル・トレンドを使用して、製造・組立施設の計画、設計、構築、運用を行っており、効率向上と不良品削減に貢献しています。また、Oxford社は、ロボティクスとオートメーションのパイプライン全体のエンドツーエンドのシミュレーションを含む製造プロセスにOmniverseを取り入れ、時間とコストを削減しています。私たちは、自動車、Microsoft Azureで利用可能なデジタル化、仮想工場シミュレーションエンジン、自律走行車シミュレーションエンジンの2つの新しいOmniverseクラウドサービスを発表しました。自動車部門に話を移します。

エヌビディアのドライブやSoCをベースとした自動運転プラットフォームの継続的な成長と、グローバルOEM顧客とのAIコックピット・ソリューションの拡大が主な要因です。当社はフォックスコンとの自動車向けパートナーシップを拡大し、当社の次世代車載用SoCであるエヌビディア・ドライブ4を含めた。FoxconnはEVのODMになりました。私たちのパートナーシップは、Foxconnに標準的なAVセンサーとコンピューティング・プラットフォームを提供し、顧客が最先端の安全でセキュアなソフトウェア定義自動車を簡単に構築できるようにします。

次に損益計算書の残りの部分に移ります。GAAPベースの売上総利益率は74%に、非GAAPベースの売上総利益率は75%に拡大しました。これは、データセンターの売上高が増加したことと、Ampere GPUアーキテクチャ製品に関連する予約済み在庫の放出による1%ポイントの利益を含む、正味在庫引当金の減少によるものです。前四半期比で、GAAPベースの営業費用は12%増、非GAAPベースの営業費用は10%増となりましたが、これは主に報酬手当の増加を反映したものです。2024年度第4四半期に話を移します。

総収益は200億ドル、プラスマイナス2%を見込んでいます。前四半期比では、コンピュートとネットワーキングの需要が引き続き旺盛なデータセンターが牽引し、大幅な伸びを見込んでいます。ゲーム事業は、ノートPCの季節性により合致しているため、今後は前四半期比で減少する可能性が高い。GAAPベースの売上総利益率は74.5%、非GAAPベースの売上総利益率は75.5%、プラスマイナス50bpを見込んでいる。

GAAP基準の営業費用は約31億7,000万ドル、非GAAP基準の営業費用は約22億ドルとなる見込みです。GAAP基準および非GAAP基準のその他の収益および費用は、非関連投資からの損益を除き、約2億ドルの収益となる見込みです。GAAPおよびnon-GAAPベースの税率は、個別項目を除き15%プラスマイナス1%を見込んでいる。詳細な財務情報は、IRウェブサイトでご覧いただける別のコメントなどに含まれています。

最後に、金融業界向けの今後のイベントをいくつかご紹介します。11月28日にアリゾナ州スコッツデールで開催されるUBSグローバル・テクノロジー・カンファレンス、11月29日にカリフォルニア州ランチョ・パロス・バーデスで開催されるウェルズ・ファーゴTMTサミット、12月7日にアリーナ・バーチャル・テック・カンファレンス、1月8日にサンフランシスコで開催されるJPモルガン・ヘルスケア・カンファレンスに出席します。第4四半期および2024年度の業績に関する決算説明会を2月21日(水)に予定しています。ご質問をお受けいたします。

オペレーター、質問をお願いします。

質疑応答

オペレーター

[オペレーターの指示に従ってください。ご質問は1件に限らせていただきます。最初のご質問はバンク・オブ・アメリカのヴィヴェック・アリヤさんからです。お待たせしました。

ヴィヴェク・アーリャ — バンク・オブ・アメリカ・メリルリンチ — アナリスト

私の質問を受けていただきありがとうございます。第4四半期にどのような中国での貢献を見込んでいるのか、明らかにしておきたいと思います。それから、ジェン・フスンさんへの質問です。ジェネレーティブAI市場への出荷について、導入曲線のどのあたりにいるとお考えですか?というのも、御社のデータセンターの成長の軌跡を見ると、来年のデータセンターへの支出は全体の30%近くになるでしょう。

では、どのような指標に注目して、成長を続けられると判断しているのでしょうか?また、御社製品のジェネレーティブAI市場への導入曲線はどのような状況でしょうか?ありがとうございました。

コレット・クレス — エグゼクティブ・バイスプレジデント兼最高財務責任者

まず、ビベックさんからの質問ですが、輸出規制と、第4四半期の見通しとガイダンスで示した影響についてです。過去数四半期において、中国やその他の影響を受ける地域は、当社のデータセンター収益の20%から25%程度を占めていました。今回のガイダンスでは、第4四半期に入るとこの割合が大幅に減少すると予想しています。輸出規制は当社の中国ビジネスにマイナスの影響を与えるでしょうし、長期的に見てもその影響の大きさについてはよく見えていません。

しかし、当社はデータセンター製品ポートフォリオを拡大し、ライセンスを必要としない新たな規制対応ソリューションを提供できるよう取り組んでいます。これらの製品は、今後数カ月のうちに利用可能になるかもしれません。しかし、第4四半期の売上高に占めるこれらの製品の寄与は、それほど大きくはないと考えています。

Jen-Hsun Huang — プレジデント兼最高経営責任者(CEO

ジェネレーティブAIは、ソフトウェアとハードウェアのTAM拡大としては過去数十年で最大のものです。その中核にあるのは、本当にエキサイティングなのは、検索ベースのコンピューティング・アプローチが大部分を占めていたことです。それが今、生成的な手法で補強され、ほとんどすべてを変えました。テキストからテキストへ、テキストから画像へ、テキストからビデオへ、テキストから3Dへ、テキストからタンパク質へ、テキストから化学物質へ。

これらは過去に人間が処理し、タイプしていたもので、今ではジェネレイティブ・アプローチになっている。データへのアクセス方法も変わった。以前は明示的なクエリに基づいていましたが、今では自然言語クエリ、意図クエリ、意味クエリに基づいています。ですから、SAPやDropbox、その他多くの企業との協業に興奮しています。

本当にインパクトのある分野のひとつは、約1兆ドル規模のソフトウェア産業が、過去数十年にわたって手作業で使用するツールを構築してきたことです。そして今、コパイロットやアシスタントと呼ばれる全く新しい分野のソフトウェアが登場し、これらのツールを手動で使用する代わりに、コパイロットが使用を手助けしてくれるようになりました。そして、ソフトウェアのライセンスを取得する代わりに、もちろんライセンスは継続しますが、ソフトウェアの使用を手助けしてくれるコパイロットやアシスタントを雇うことになります。これらのコパイロットやシステムをすべてAIのチームにつなげ、それが現代版ソフトウェア、現代版エンタープライズ・ビジネス・ソフトウェアになるのです。

つまり、ソフトウェアとソフトウェアのあり方の変革が、その下にあるハードウェアを動かしているのです。そして、2つの方法で変容していることがわかります。ひとつは、ジェネレーティブAIとは無関係なものです。2つのトレンドがある。

ひとつはアクセラレーテッド・コンピューティングに関するものです。汎用コンピューティングはエネルギーとコストの無駄が多すぎます。アクセラレーテッド・コンピューティングと呼ばれる、はるかに優れたアプローチがある今、アクセラレーテッド・コンピューティングを使うことで、1桁のエネルギーを節約でき、1桁の時間を節約でき、1桁のコストを節約できる。アクセラレーション・コンピューティングは、いわば汎用コンピューティングをこの新しいアプローチに移行させるものです。

さらに、新しいクラスのデータセンターも加わりました。今お話にあったような従来のデータセンターは、私たちがその3分の1を占めています。しかし、新しいクラスのデータセンターもあります。この新しいクラスのデータセンターは、過去のデータセンターとは異なり、同じインフラを使用するさまざまなテナントが多くのアプリケーションを実行し、データセンターには多くのファイルが保存されています。

これらの新しいデータセンターでは、基本的に1つのテナントが1つのアプリケーションを使用することはあっても、アプリケーションはごく少数です。そしてデータを処理する。モデルを訓練し、トークンを生成し、AIを生成する。私たちはこうした新しいデータセンターをAIファクトリーと呼んでいます。

私たちは、このような新しいデータセンターをAIファクトリーと呼んでいます。そして、この新しいコンピューティング・アプローチへの拡大、移行を見ると、最初の波は大規模な言語モデルのスタートアップ企業、ジェネレーティブAIのスタートアップ企業、消費者向けインターネット企業でした。そして現在、私たちはその取り組みを強化している最中です。その一方で、そのような動きも活発化しています。

チャットボットやコピロット、アシスタントを構築し、自社のプラットフォーム上にあるツールを増強したいと考えている企業向けソフトウェア会社と提携し始めています。GPUに特化したCSPが世界中に出現しており、AI処理という本当に一つのことに特化しています。自国のデータを活用し、自国のデータを保持し、自国の文化を保持し、データを処理し、自国のAIを開発する必要があることを認識している主権的なAIインフラ、人々、国々が見られます。インドを見ればわかるだろう。

スウェーデンでは1年ほど前に、日本では先週、フランスで大きな発表がありました。先週はフランスで大きな発表があった。しかし、構築されつつあるソブリンAIクラウドの数は実にかなりのものだ。私の推測では、ほぼすべての主要地域が、そして確実に、すべての主要国が独自のAIクラウドを持つことになるでしょう。

生成的AIの波があらゆる産業、あらゆる企業、あらゆる地域に伝播していく中で、新たな展開が見られると思います。私たちは今、このコンピューティングの変遷の始まりにいるのです。

オペレーター

次のご質問はウェルズ・ファーゴのアーロン・レイカーズさんからです。お待たせしました。

アーロン・レイカーズ — ウェル・ファーゴ証券 — アナリスト

はい。ご質問をありがとうございます。ネットワーク事業についてお聞きしたいのですが。今お話にあったような成長率を考えると、前年比155%だと思います。

前年比155%、前四半期比でも力強い成長だと思います。この事業は四半期ベースで25億ドルから30億ドルのレベルに近づいているように見えます。また、来年に向けてEthernetがInfiniBandだけでなく、ネットワーキングの一部になっていくと思いますが、従来のEthernetスタックに対するSpectrum Xの差別化についてどのようにお考えでしょうか。ありがとうございました。

Jen-Hsun Huang — プレジデント兼CEO

そうですね。ご質問ありがとうございます。当社のネットワーキング・ビジネスは、すでに100億ドル以上のランレートに達しています。そして、今後もさらに拡大していくでしょう。

また、ご指摘の通り、私たちは最近、ネットワーキング・ビジネスに新しいネットワーキング・プラットフォームを追加しました。大規模なAI専用工場の大半は、InfiniBandを標準としています。その理由は、そのデータレートとレイテンシーだけでなく、ネットワーク上でトラフィックを移動させる方法が本当に重要だからです。AIを処理する方法とマルチテナントのハイパースケール・イーサネット環境では、トラフィック・パターンが根本的に異なります。

InfiniBandとSoftware-Defined Networkを使えば、輻輳制御、アダプティブ・ルーティング、パフォーマンス・アイソレーション、ノイズ・アイソレーションはもちろんのこと、InfiniBandのデータ・レートと低レイテンシー、そしてInfiniBandの自然な部分である非常に低いオーバーヘッドを実現できます。InfiniBandは単なるネットワークではありません。コンピューティング・ファブリックでもあります。私たちは、計算を含む多くのソフトウェア定義機能をファブリックに組み込みました。

浮動小数点演算や計算をスイッチ上で行い、ファブリック自体で行います。イーサネットとInfiniBandの違いは、AI工場向けのInfiniBandとイーサネットの違いが劇的な理由です。その差は非常に大きく、その理由は、AI工場向けに20億ドルのインフラに投資したところで、全体的な効果に20%、25%、30%の差があれば、特に規模を拡大すればするほど、数億ドルの価値で測定されるからです。また、そのインフラを4、5年かけてレンタルしていたとしたら、それは本当に大きな額になります。

このように、AI工場にとってInfiniBandの価値提案は否定できない。しかし、AIをエンタープライズに移行させ、すべての企業が独自のカスタムAIを構築できるようにしたい。私たちは、自社独自のデータ、自社独自のスキルに基づいて、自社で顧客AIを構築しています。例えば最近、私たちが作っているモデルのひとつについてお話しました。

チップ・ニモというモデルだ。他にもたくさん作っています。社内で作成するカスタムAIモデルは数十から数百になるだろう。そして私たちの会社は……私たちの従業員全員にとって、モデルの訓練に使うAI工場ほど高性能である必要はありません。

ですから、私たちはAIがイーサネット環境で動作できることを望んでいます。そこで私たちは、イーサネットを拡張する新しいプラットフォームを開発しました。イーサネットを置き換えるのではなく、イーサネットに100%準拠し、東西トラフィックに最適化されています。ブルーフィールドとスペクトラム・スイッチによるエンド・ツー・エンドのソリューションでイーサネットに追加し、InfiniBandにある機能の一部を実行できるようにしました。

私たちが市場に投入する方法は、すでに私たちのコンピューティング・ソリューションを提供している大企業のパートナーとともに市場に投入することです。HPLとレノボは、エヌビディアのAIスタック、エヌビディアのエンタープライズ・ソフトウェア・スタックを持っています。HPLとレノボは、エヌビディアのエンタープライズ・ソフトウェア・スタックであるエヌビディアAIスタックを持っています。そして今、彼らはBlueFieldと統合し、さらに彼らのSpectrumスイッチをバンドルして市場に投入することで、彼らの膨大な販売力と再販業者の膨大なネットワークを使って、世界中の企業顧客に、完全に統合された、言うなれば完全に最適化された、少なくともエンドツーエンドのAIソリューションを提供できるようになります。つまり、これは基本的に世界の企業向けにイーサネットにAIを導入することなのです。

オペレーター

次のご質問は、モルガン・スタンレーのジョー・ムーアさんからです。お待たせしました。

ジョー・ムーア — モルガン・スタンレー — アナリスト

わかりました。ありがとうございます。Grace Hopperについてもう少しお聞かせ願えればと思いますが、マイクロプロセッサーを活用する能力をどのようにお考えでしょうか。また、従来のH100アプリケーションに対して、どのようなアプリケーションでGrace Hopperを使うとお考えですか?

Jen-Hsun Huang — プレジデント兼最高経営責任者(CEO

そうですね。ご質問ありがとうございます。グレース・ホッパーは現在、大量生産を行っています。来年には、ハイパフォーマンス・コンピューティングとAI、AIインフラストラクチャーにおけるすべてのデザインウィンを獲得できると考えています。

最初のデータセンター向けCPUから数十億ドル規模の製品ラインまで、非常に速いスピードで立ち上がりつつあります。これは当社にとって非常に大きな製品ラインとなるでしょう。グレース・ホッパーの能力は実に素晴らしいものです。グレース・ホッパーは、超高速メモリと超大容量メモリを同時に搭載したコンピュート・ノードを作る能力を備えています。

ベクター・データベースや意味検索の分野では、REG(検索拡張世代)と呼ばれるもので、生成的なAIモデルを持つことができ、応答を生成する前に独自のデータや事実データを参照することができます。そのデータは非常に大きい。また、コンテキストの長さが非常に長いアプリケーションや生成モデルも考えられます。基本的に、質問をする前にシステム・メモリに本全体を保存することになります。

そのため、コンテキストのリンクは非常に大きくなります。こうすることで、退化的なモデルは、一方ではまだあなたと自然に対話することができ、他方では、事実データ、独自のデータ、またはドメイン固有のデータ、より新しいデータを参照することができ、継続的に関連し、幻覚を減らすことができます。例えば、グレース・ホッパーにとって、このような特定のユースケースは本当に素晴らしいものです。また、X86とは異なるCPUを持ちたいと考えている顧客、たとえばヨーロッパのスーパーコンピューティング・センターや、独自のARMエコシステムを構築したいと考えているヨーロッパの企業、あるいはスタックを構築したいと考えているCSP、あるいは自社のカスタムCPUがARMベースであるためARMに軸足を移したいと考えているCSPなどにも適しています。

グレース・ホッパーの成功にはさまざまな理由がありますが、私たちは素晴らしいスタートを切りました。これはホームラン商品です。

オペレーター

次のご質問はUBSのティム・アルクリさんからです。回線は開いています。

ティム・アーキュリ — UBS — アナリスト

ありがとうございます。収益の見通しについて少しお聞きしたいと思います。一方では、購入コミットメントがまた大幅に増えました。

しかし一方で、中国以外の需要を満たすことができれば、チャイナ・バンドは間違いなく入ってくるでしょう。だから、まだ2024年に入っていないのは知っている。Jen-Hsunさんは来年がデータセンターの収益のピークになるとは考えていないようですが、私はそれを明確にお聞きしたかったのです。データセンターは2025年まで成長できると思いますか?ありがとうございます。

Jen-Hsun Huang — プレジデント兼最高経営責任者(CEO

データセンターは2025年まで成長できると確信しています。もちろん、それにはいくつかの理由があります。私たちは供給を大幅に拡大しています。私たちはすでに、世界で最も広範で最大かつ有能なサプライチェーンを獲得しています。

GPUはチップだと思われていますが、HGX、H100、Hopper HGXには35,000個の部品があります。重さは70ポンド。チップのうち8つがホッパーです。残りの35,000個はそうではありません。

HGXの受動部品は、高電圧部品、高周波部品、大電流部品で構成されている。スーパーコンピューターなので、スーパーコンピューターを別のスーパーコンピューターでテストする唯一の方法なのだ。製造も複雑、テストも複雑、出荷イベントも複雑、設置も複雑。このように、HGXのサプライチェーンはあらゆる面で複雑なのです。

HDXのすべてがMBAネットワークで接続されていることは言うまでもありませんが、ここにいる優秀なチームは、サプライチェーンを信じられないほどスケールアウトしています。ですから、私はただ……まず第一に、この素晴らしいサプライチェーンを拡大したチームを超誇りに思っています。私たちは世界トップクラスです。しかしその一方で、私たちは新しい顧客と新製品を増やしています。

だから、新しい供給がある。新しい顧客もいる。先ほど申し上げたように、さまざまな地域でGPU専門クラウドが立ち上がっています。世界各地からソブリンAIクラウドが立ち上がってきており、自国の知識、自国の文化を輸出してAIを再販してもらうわけにはいかないという認識が広まっています。

そうすべきなのだ。彼らにはスキルがあり、我々と協力することで、その国のAIを構築する手助けをすることができる。そして、彼らが最初にしなければならないことは、AIクラウドを構築することです。また、私たちはエンタープライズ市場にも進出しています。

エンタープライズ市場には、2つの道と1つの道、あるいは3つの道があります。前半は、もちろん既製のAIです。もちろん、Chat-GPTのような素晴らしい既製AIもありますし、他にもあるでしょう。ServiceNowやSAPのようなソフトウェア企業は、自社のインテリジェンスを外部に委託するわけにはいきません。

そして、彼らはツールを構築している。そして、そのツールの上に、カスタムで独自の、ドメイン固有のコパイロットやアシスタントを構築し、顧客ベースに貸し出すべきだ。これは……彼らは金鉱の上に座っているのだ。世界中の主要なツール会社のほとんどが金鉱の上に座っている。

彼らは、自分たちでカスタムAIを構築しなければなりません。私たちはAIファウンドリーと呼ばれる新しいサービスを提供しており、NVSの機能を活用することで、そのような企業にサービスを提供することができます。そして次は、企業が独自のカスタムAIやカスタムチャットボット、独自のカスタムを構築することです。この能力は世界中に広がっています。

私たちがこの市場にサービスを提供する方法は、エヌビディアのAIエンタープライズと呼ばれるソフトウェア・スタックを実行するコンピュート、ネットワーク、スイッチなどのシステム・スタック全体を、HP、デル、レノボなどの市場パートナーを通じて提供することです。新興企業やCSPから始まり、コンシューマー・インターネット企業、エンタープライズ・ソフトウェア・プラットフォーム、エンタープライズ企業へと、ジェネレーティブAIの波が押し寄せています。そして、最終的には、私たちが多くのエネルギーを費やしている分野の1つに、産業用ジェネレーティブAIがあります。これはNVIDIA AIとNVIDIA Omniverseが一緒になるところです。

これは本当にエキサイティングな仕事です。私たちは今、産業界全体がジェネレーティブAIからアクセラレーテッド・コンピューティングへと移行している最中です。これは、あらゆる企業、あらゆる産業、あらゆる国に影響を与えるでしょう。

オペレーター

次のご質問はゴールドマン・サックスの針俊哉さんからです。お待たせしました。

針 俊也 — ゴールドマン・サックス証券 — アナリスト

どうもありがとうございます。コレットさんにも少しお聞きしたいことがあるのですが、それからジェン・フスンさんにも質問させてください。コレットは、今後2、3ヶ月の間に規制に対応した製品を導入すると言っていましたが、第4四半期の収益への貢献は比較的限定的なものになるはずです。

それはタイミングの問題ですか?また、それが4月以降のディッカーの成長再加速の要因になる可能性はありますか?それとも、今後の収益への貢献が比較的限定的となるような価格設定なのでしょうか?そしてJen-Hsunへの質問。先週発表されたAIファウンドリーサービスについてお伺いしたいのですが、できればもう少し詳しくお聞かせいただければと思います。収益化モデルはどうなるのでしょうか?サービスやソフトウェアの収益が中心なのでしょうか?長期的なオポチュニティセットについてどう考えるべきか?また、これはマイクロソフトだけのものになるのでしょうか、それとも他のパートナーにも拡大する計画があるのでしょうか?ありがとうございました。

コレット・クレス — エグゼクティブ・バイスプレジデント兼最高財務責任者

わかりました。ありがとうございます。中国のお客様に提供できる可能性のある新製品に関する質問ですが、これは両社にとって重要なプロセスです。このような新製品を設計・開発するのは非常に重要なプロセスです。

議論したように、私たちはこれらの製品に関してもアメリカ政府と十分に話し合うつもりです。当四半期の状況を考えると、当四半期はすでに数週間が経過しており、この2つの製品のニーズや要望について顧客と話し合うには時間がかかりそうです。そして今後、中期的なものであれ長期的なものであれ、米国政府と中国との間でどのような製品を生産できるかということについては、何とも言えません。

アメリカ政府と中国の顧客との間で、私たちが何を生産することができるのか、その両方のアイデアを言うのは難しいのです。ですから、私たちは中国の顧客のために適切なバランスを見つけることに集中していますが、現時点では何とも言えません。

Jen-Hsun Huang — プレジデント兼最高経営責任者

ご質問ありがとうございます。世界には、AIファウンドリーにとって輝かしい機会があります。そしてそれは非常に理にかなっています。まず、どの企業にもコア・インテリジェンスがあります。

それが私たちの会社を構成しています。私たちのデータ、私たちのドメインの専門知識。多くの企業の場合、私たちはツールを作っています。そして、世界中のソフトウェア会社のほとんどは、ツールのプラットフォームです。

そしてそれらのツールは今日、人々に使われています。そして将来的には、私たちが雇った大勢のAIによって増強された人々によって使われるようになるでしょう。これらのプラットフォームは世界中に広がり、SAP、ServiceNow、Dropbox、Gettyなど多くの企業が参入する予定です。その理由は、彼らが独自のAIを持ち、独自のAIを欲しているからだ。

他社にAIを構築してもらうために、インテリジェンスを外注し、データを提供し、フライホイールを提供する余裕はない。だから、私たちのところに来るのです。TSMCがファウンドリーであるように、ファウンドリーにはAI技術が不可欠です。ご存知のように、私たちはAI技術に関して非常に深い能力を持っています。

そして第二に、ベストプラクティスとして知られる実践、つまりAIモデルの発明を通じてデータを処理し、ガードレールのように微調整された、安全なAIを作り出すスキルなどが必要です。そして3つ目が独自の工場で、DGX Cloudがそれです。私たちのAIモデルはAI基盤と呼ばれています。私たちのプロセスは、AIを作成するためのCADシステムはNEMOと呼ばれ、DGX Cloudと呼ばれるエヌビディアのファクトリー上で稼働します。

私たちのマネタイズ・モデルは、パートナー各社がDGX Cloud上のサンドボックスを借り、そこで私たちが一緒に仕事をするというものです。パートナーはデータを持ち込みます。ドメインの専門知識を持ってくる。我々は研究者とエンジニアを抱える。

私たちは、彼らがカスタムAIを構築する手助けをします。私たちは、そのカスタムAIが素晴らしいものになるよう支援します。そして、その顧客のAIは顧客のものとなり、エンタープライズ・グレード、エンタープライズ最適化、あるいはエヌビディアのすべてにわたってアウトパフォーマンス最適化されたランタイムでデプロイされます。私たちは、クラウド・オンプレムのどこにでも巨大なインストールベースを持っています。

そして、安全で、セキュアなパッチが適用され、常にパッチが適用され、最適化され、サポートされています。これをNVIDIA AIエンタープライズと呼んでいます。NVIDIA AI Enterpriseは、GPあたり年間4,500ドルです。これが我々のビジネスモデルです。

我々のビジネスモデルは基本的にライセンスです。基本的なライセンスがあれば、その上に収益化モデルを構築することができます。多くの点で、私たちは卸売業です。小売りになる。

サブスクリプション・ライセンスをベースにすることもできます。インスタンス単位でもいいし、使用量単位でもいい。しかし、私たちのビジネスモデルは基本的に、オペレーティング・システムのようなソフトウェア・ライセンスのようなものです。私たちのビジネスモデルは、カスタムモデルの作成を支援し、NVIDIA AI Enterprise上でカスタムモデルを実行するというものです。

そして、素晴らしいスタートを切ることができました。NVIDIA AI Enterpriseは当社にとって非常に大きなビジネスになるでしょう。

オペレーター

次のご質問は、バーンスタイン・リサーチのステイシー・ラスゴンさんからです。どうぞよろしくお願いいたします。

ステイシー・ラスゴン — バーンスタイン・リサーチ — アナリスト

こんにちは。私の質問に答えてくれてありがとう。コレット、もし中国の規制がなかったら、第4四半期はもっと高い数字になっていたのでしょうか?それとも、中国に行くはずだったものを他の場所に再出荷するという供給上の制約があったのでしょうか?また、データセンターのリードタイムについても教えてください。また、中国への再出荷によって、すぐに出荷可能な部品が手に入り、リードタイムが短縮されているのでしょうか?

コレット・クレス — エグゼクティブ・バイスプレジデント兼最高財務責任者

そうですね。ステイシー、ご理解いただけるでしょうか。そうですね、四半期ごとに供給を改善するために取り組んでいる状況です。私たちは毎期、収益を確保するため、本当に堅実な仕事を続けてきました。

しかし、中国がなくなったことで、第4四半期の見通しについては、確かに、供給制約がなければ中国に売ることができたものもあったかもしれませんが、今はもう売ることができません。では、第4四半期のガイダンスはもう少し高くなる可能性はありましたか?はい。私たちはまだ供給の改善に取り組んでいますし、来年もそれに向けて成長し続けるつもりです。

オペレーター

次のご質問はTDコーウェンのマット・ラムジーさんからです。お待たせしました。

マット・ラムジー — TDコーウェン — アナリスト

ありがとうございます。皆さん、決算おめでとうございます。Jen-Hsun、私はあなたに2つの部分からなる質問をしました。その前提とは、AIトレーニングがエヌビディアの支配的な領域であり、推論、それも大規模なモデル推論がTAMの多くを占めるようになると、市場の競争が激しくなり、差別化ができなくなる、などと考えている投資家からの質問がいまだに多いということです。

そこで、質問の2つの部分は、1つ目は、LLMに移行する際の推論ワークロードの進化と、御社が小規模なモデル推論ではなく、それに対してどのような位置づけにあるのかについて、少し時間を割いてお話しいただけないでしょうか。2つ目は、1、2ヶ月前まで、AIワークロードのデータ処理部分について全く質問を受けたことがありませんでした。つまり、学習前、学習と推論の間、推論後のデータ操作です。今では、それがワークロードの大部分を占めていると思います。

CUDAがワークロードのこれらの部分をどのように高速化するかについて、お話しいただけますか?ありがとうございます。

Jen-Hsun Huang — プレジデント兼最高経営責任者(CEO

推論は複雑です。実際、非常に複雑です。今期、TensorRT LMという最もエキサイティングなコンパイラ最適化エンジンを発表しました。

評判は上々です。GitHubに行ってみてください。世界中のスタックやフレームワークに、ほとんど瞬時に統合されています。それにはいくつかの理由があります。

私たちがTensorRT LLMを開発できたのは、CUDAがプログラマブルだからです。もしCUDAとGPUがそれほどプログラマブルでなかったら、私たちがこのペースでソフトウェアスタックを改良することは本当に難しかったでしょう。TensorRT LLMは、同じGPU上で、誰も何も触れることなく、パフォーマンスを2倍向上させます。それに加えて、私たちの技術革新のペースはとても速いのです。

H200はそれをさらに2倍にします。そして、推論性能は、推論コストを別の言い方をすれば、約1年の間に4分の1になったのです。だから、これを維持するのは本当に大変なことなんだ。さて、なぜ私たちの推論エンジンが皆に支持されるかというと、私たちのインストールベースがあるからです。

私たちは20年、20年以上にわたってインストールベースに専念してきました。私たちのインストールベースは、あらゆるクラウドで最大であるだけでなく、あらゆるエンタープライズ・システム・メーカーで利用可能です。あらゆる業界の企業に利用されています。そして、NVIDIAのGPUを見るときはいつでも、当社のスタックを実行しています。

アーキテクチャ的にも互換性があります。これは、私たちが非常に長い間専念してきたことです。私たちは、それについて非常に規律正しいのです。言ってみれば、アーキテクチャの互換性を第一に考えています。

そしてそれが、当社のプラットフォームの安定性の確かさを世界に伝えてきました。NVIDIAのプラットフォームの安定性が確実であるからこそ、誰もがNVIDIAを最初に構築し、NVIDIAを最初に最適化するのです。NVIDIAの上に構築するすべてのエンジニアリングとすべての作業、すべての技術の発明は、NVIDIAのGPUを使用するすべての人に利益をもたらします。もしあなたが推論プラットフォームで、推論アプリケーションをデプロイしているのなら、あなたは基本的にアプリケーション・プロバイダであり、ソフトウェア・アプリケーション・プロバイダとして、大規模なインストール・ベースを求めていることになります。

データ処理では、モデルをトレーニングする前に、データを補強しなければならない。データをデバッグし、合成データでデータを補強する必要があるかもしれません。そのため、データをきれいにし、データを整列させ、データを正規化する必要がある。テラバイトやペタバイト単位で測定される。

そして、データエンジニアリングの前に行うデータ処理の量は、トレーニングの前に行うデータ処理の量よりもかなり大きい。最終的な作業量の30%、40%、50%を占めるかもしれない。最終的にデータ駆動型の機械学習サービスを構築する上で、データ処理は非常に重要です。ですから、データ処理は非常に重要な部分なのです。

私たちはSparkを加速させます。Pythonを加速させます。最も素晴らしいことのひとつは、CuDF Pandasと呼ばれるものです。Pandasは、世界で最も成功したデータサイエンス・フレームワークですが、今ではNVIDIA CUDAによって加速され、コードを1行も書くことなく、すぐに使えるようになっています。

このアクセラレーションは本当に素晴らしいものです。人々は信じられないほど興奮しています。Pandasは、データサイエンスのためのデータ処理という、たった一つの目的のために設計されました。そして、NVIDIA CUDAはそのすべてを提供します。

オペレーター

最後のご質問は、JPモルガンのハーラン・サーさんからです。どうぞよろしくお願いいたします。

ハーラン・サー — JPモルガン・チェース・アンド・カンパニー — アナリスト

こんにちは。私の質問にお答えいただきありがとうございます。ハイテク業界の歴史を見てみると、成功している企業は常にエコシステム・シリコン、ハードウェア、ソフトウェア、強力なパートナーシップ、そして同じくらい重要なことですが、新製品の積極的な投入、長期的なセグメンテーションに注力してきました。チームは最近、より積極的な新製品ケイデンスとデータセンターを2年前から発表し、今では毎年、より高いレベルのセグメンテーション、トレーニング、最適化、推論、CPU、GDP、GPUネットワーキングを発表している。

より積極的で拡大するロードマップをサポートするために、研究開発費の伸びをどのように考えればいいのでしょうか?また、より重要なこととして、このような複雑な状況を管理し、実行に移すために、チームはどのような取り組みを行っているのでしょうか?

Jen-Hsun Huang — プレジデント兼最高経営責任者(CEO

本当に素晴らしいですね。あなたはエヌビディアのビジネスプランを書いたばかりです。そして私たちの戦略を説明してくれました。まず第一に、私たちが実行を加速する根本的な理由があります。

その理由は、根本的にコストを下げるからです。TensorRT LLMと200の組み合わせにより、大規模モデル推論のコストが4分の1になりました。もちろん、スピードやフィードも含まれますが、ほとんどはソフトウェアによるものです。そのため、ロードマップを加速させたいと考えています。

2つ目の理由は、ジェネレーティブAIのリーチを拡大することです。世界のデータセンターの構成数は、驚くべきものです。エヌビディアはあらゆるクラウドに参入していますが、どのクラウドも同じではありません。エヌビディアはあらゆるクラウドサービスプロバイダーと協業していますが、そのネットワーキングのコントロールプレーンのセキュリティ態勢は一つも同じではありません。

プラットフォームは皆違います。しかし、エヌビディアはそのすべてのスタック、すべてのデータセンターに統合されており、そのすべてと驚くほどうまく機能しています。そして言うまでもなく、私たちはすべてを取り込んで、スタンドアローンのAI工場を作ったわけではありません。我々のプラットフォームを利用する。

スーパーコンピューターにも導入できる。企業にも導入できる。AIを企業に導入することは、ジェネレーティブなAIを企業に導入することであり、誰もやったことのないことです。私たちは今、そのすべてを市場に投入しているところです。

その複雑さには、もちろん、すべてのテクノロジーやセグメント、ペースが含まれます。そして、私たちが作成するすべてのドメイン固有のライブラリです。その理由は……どのコンピューター会社も、何も考えずにエヌビディアをロードマップに統合し、市場に投入することができます。市場需要があるからです。

もちろん、AIや金融サービス、スーパーコンピューティング、量子コンピューティングにも需要があります。私たちが特定分野に特化したライブラリを持っている市場やセグメントのリストは、信じられないほど広範囲にわたります。そして最後に、データセンター向けのエンド・ツー・エンドのソリューションです。インフィニバンド・ネットワーク、インフィニバンド・ネットワーキング、イーサネット・ネットワーキング、x86 ARMなど、あらゆるソリューション、テクノロジー・ソリューション、ソフトウェア・スタックを提供しています。

そしてそれは、最大数のエコシステム・ソフトウェア開発者、システム・メーカーの最大エコシステム、最大かつ最も広範な販売パートナーシップ・ネットワーク、そして最終的には最大のリーチを持つことにつながります。そしてそれは、確かに多くのエネルギーを必要とする。しかし、それを支えているのは、何十年も前に私たちが下した偉大な決断なのですが、すべてがアーキテクチャー的に互換性があるということです。あるGPUで動作するドメイン固有言語を開発すると、すべてのGPUで動作します。

TensorRTをクラウド用に最適化すれば、エンタープライズ用に最適化されます。新機能、新ライブラリ、新機能、あるいは新しい開発者を取り込むようなことをすれば、その開発者は即座に、私たちのすべてのリーチの恩恵を受けることができます。このような規律、アーキテクチャ互換の規律が、数十年以上続いていることが、エヌビディアが今でも非常に効率的である理由のひとつです。私たちは28,000人の従業員を抱え、世界中のあらゆる企業、あらゆる産業、あらゆる市場にサービスを提供しています。

オペレーター

ありがとうございました。それでは、ジェンスン・フアンさんによる閉会のご挨拶に代えさせていただきます。

Jen-Hsun Huang — プレジデント兼最高経営責任者

当社の力強い成長は、汎用コンピューティングからアクセラレーテッド・コンピューティング、そしてジェネレーティブAIへの幅広い産業プラットフォームの移行を反映しています。大規模な言語モデルの新興企業、コンシューマー・インターネット企業、グローバル・カット・サービス・プロバイダーが最初のムーバーです。次の波が押し寄せ始めている。国や地域のCSPは、地域の需要に応えるためにAIクラウドを構築している。

アドビやドロップボックス、SAP、ServiceNowのようなエンタープライズ・ソフトウェア企業は、自社のプラットフォームにAIコパイロットやアシスタントを追加している。また、世界最大の産業分野の企業は、自動化と生産性向上のためにカスタムAIを開発している。ジェネレーティブAIの時代が本格化し、データの精製やトレーニング、推論、AIの生成に最適化された、新しいタイプのデータセンターとAIファクトリーの必要性が生まれている。AI工場のワークロードは、ITタスクをサポートするレガシーデータセンターのワークロードとは異なり、インクリメンタルである。

AIファクトリーはコパイロットやAIアシスタントを実行し、ソフトウェアTAMを大幅に拡大し、1兆ドルの従来型データセンター・インフラのインストールベースを拡大し、AI産業革命を力づける、大規模な新規投資を推進している。InfiniBandとNVIDIA AIソフトウェアスタックを搭載したNVIDIA H100 HGXは、今日のAI工場を定義しました。世界の需要に応えるためにサプライチェーンを拡大する一方で、AIの次の波に向けた新たな成長ドライバーも構築しています。CPU、ネットワーキング、そしてソフトウェアとサービスです。

GraceはNVIDIA初のデータセンター向けCPUです。GraceとGrace Hopperはフル生産体制にあり、CPUの選択とは関係なく、来年には数十億ドル規模の新たな製品ラインへと急成長する。我々は、顧客がAI工場を建設するのを支援することができる。エヌビディアのネットワーキングは現在、年間売上高100億ドルを超えている。

InfiniBandは前年比5倍の成長を遂げ、AI工場のネットワーキングとして今後素晴らしい成長を遂げる位置にある。企業もAI導入に向けた競争を繰り広げており、イーサネットは標準的なネットワーキングとなっています。今週、当社は企業向けのAI用イーサネット・プラットフォームを発表した。NVIDIA Spectrum Xは、Bluefield Super Spectrum 4イーサネット・スイッチとソフトウェアのエンドツーエンド・ソリューションで、AIワークロード向けにイーサネット性能を最大1.6倍向上させる。

Dell、HP、Lenovoは、NVIDIA AIコンピューティング、ネットワーキング、ソフトウェアの完全なジェネレーティブAIソリューションを世界の企業に提供するために、私たちに加わりました。エヌビディア・ソフトウェア&サービスは、年率10億ドルで今年を終える予定です。ServiceNowやSAPのような企業向けソフトウェア・プラットフォームは、独自のAIを構築・運用する必要がある。企業はカスタムAIコパイロットを構築し、展開する必要がある。

当社は、顧客がカスタムモデルを構築するのを支援するAI技術、専門知識、規模を有している。NVIDIA DGXクラウド上で独自のデータを使用し、エンタープライズグレードのNVIDIA AIエンタープライズ上でAIアプリケーションを展開します。NVIDIAは本質的にAIファウンドリである。NVIDIA GPU、CPU、ネットワーキング、AIファウンドリー・サービス、そしてNVIDIA AIエンタープライズ・ソフトウェアはすべて、成長エンジンとしてフル回転しています。

本日はご参加いただきありがとうございました。来期も進捗状況をご報告できることを楽しみにしています。

最新の株価

出所:FINVIZ(https://finviz.com/)

↓ポチッと応援よろしくお願いいたします↓

(米国株ブログランキングへ飛びます)

![]()

にほんブログ村

Twitterもフォローいただければ嬉しいです。

コメント